【转】VPN Tunnel 口MTU问题解决

作者:易隐者 发布于:2012-12-24 14:00 Monday 分类:案例讨论

【说在之前】:

1,这个帖子是我在锐捷的论坛里看到的,现象很特别,值得研究讨论一番;

2,原帖中仅对故障做了描述,并未给出导致故障产生的根本原因,大家可以自行先考虑考虑,并尝试分析推测一下可能的原因,可在此贴下留言以供探讨;

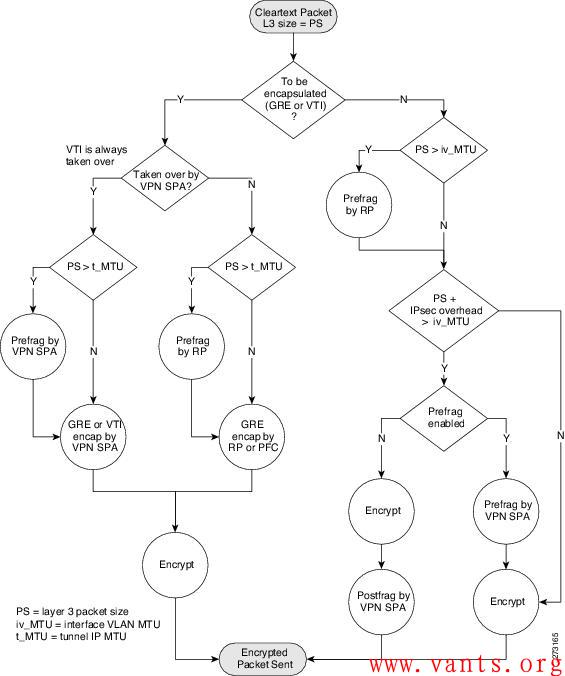

3,此案例的正确答案应该已由回复中的liuquyong兄弟给出,主要原因在于加解密次数的减少导致了ERP交互性能的提升。关键就在于下面这张来自于思科的加解密流程图:

【原文连接】:

http://support.ruijie.com.cn/showtopic-22758.aspx

【原文全文】:

Gre隧道,Tunnel接口的MTU值设置为大于1500的值,有效吗?带着这个问题我讲讲今天遇到的问题:

NPE20(总部,版本RGNOS 9.12)与NBR300(分部,版本RGNOS 9.12)建立Tunnel 0接口的GRE隧道。

2010年初的时候刚开始用Tunnel功能,当时show interface tunnel 0 显示的 Tunnel 的 MTU值 1464,此时分部访问总部的ERP(用友U890,C/S架构,通过Tunnel隧道来访问的)很慢,卡!只要一遇到分部客户端与服务器之间有数据交互的时候,就异常的卡,有时软件直接无响应。

命令行将此Tunnel的MTU值设置为65535,此时访问速度“嗖”的立刻上去,只能用两个字形容:流畅!

前天,我将NPE20和NBR300都升级到最新的9.17 2P1 B4版本,9.17的Web控制界面操控性以及网速都有一定的提升,但这时出现问题,Tunnel的MTU值设置为65535之后,会自动变回1464,企业内的应用再度变卡,就和上述曾经遇到的卡的情况一样。并且无论如何都不像9.12版本那样保持65535。

此问题一直延续到今天。于是迫于无奈,在咨询了锐捷400电话客服之后,由3034号客服帮我将NPE20、NBR300都刷回9.12版本。刷回9.12版本之后的tunnel 0 先是保持1464默认值,这时还是卡,没有任何起色。手动将MTU值设置为65535,分部访问总部的ERP访问速度和响应速度一下子就上去了,非常流畅!

在咨询3034客服之前,我也咨询过几个客服关于MTU值的问题,得到的答案基本上都是类似于“公网传输数据包的MTU 最大只能1500" 、 “你设置为65535实际上没有效果”之类的话。并且让我两端互ping来测试是否丢包,互ping的时候的确是不丢包的,就算互ping的时候的指定ping包的大小也基本不丢包。

但是我想说,这只是理论,而我所遇到的问题是事实,事实胜于雄辩,Tunnel 0 的MTU为1464时与65535时相比,企业分部与总部之间的内部应用访问速度效果提升是:绝对异常明显的!!

所以,在这里我第一想说感谢3034客服帮我恢复到9.12,这个可以保存手动设置的65535MTU值的版本。第二我想恳请锐捷能够在下一个RGNOS版本中将GRE隧道的Tunnel 接口的这个MTU值改为可以保存用户手动配置的值,比如手动设置为65535,而别再自动恢复理论默认的1464之类的值。

因为今天我遇到的问题的确是:相对与MTU1464的默认值,MTU 65535时的隧道内访问速度是:提升绝对异常明显的!所有的事实,3034号客服可以证明!问题虽解决了,但是他也比较纳闷比较难解释。

我其实很纠结,我想用9.17 2P1 B4的新特性,包括上外网的网速也有一定的提升,但是无奈只能用9.12这个老版本。

标签: 丢包 故障 交互 MTU ping tunnel接口 GRE 锐捷

版权所有:《蚂蚁网-多维人生,三实而立!》 => 《【转】VPN Tunnel 口MTU问题解决》

本文地址:http://www.vants.org/?post=207

除非注明,文章均为 《蚂蚁网-多维人生,三实而立!》 原创,欢迎转载!转载请注明本文地址,谢谢。

评论:

2013-03-06 14:58

2013-02-04 12:57

上文中,将MTU从1464设置为65535以后,在Tunnel口进行只需要进行一次加密,如果是1464则需要进行65535/1464=45次加密,由于进行45次加密会对VPN设备的CPU造成很大影响,所以在案例中表现的就是网速很慢;改成65535以后在Tunnel口只需要加密一次,所以在整个传输过程中网络很快。

2012-12-25 12:27

GRE tunnel MTU值为1464,加上GRE封装24个字节的封装,MTU已达1484;如果物理端口MTU值小于1484,则会导致分片,如果DF设置为1,会导致丢包。

至于为何修改Tunnel MTU值为65535后,访问速度得到提升,估计是tunnel mtu超过1500的设置后,会自动调整MTU大小,比方说取整,调整为1285;这样就不会导致分片或丢包了。

以上分析为个人愚见,见笑了。

2012-12-25 14:16

2012-12-26 12:36

我猜想的故障原因为:服务器与客户端之间协商MTU值应是大于1464值的,针对UDP协议,如果分包,只有第一个包有完整的端口信息,后续分包是没有的。这样导致进入GRE隧道时,进行分包的UDP包会被客户端无法重组,导致应用无响应。当tunnel MTU值设置为65535时,其实是调整了MTU值为1500,这样当UDP报文进入隧道时就不会再分包了。故网络访问比较流畅。

2012-12-25 00:16

我会尝试先从MSS着手排查问题.

MSS决定了C/S业务应用系统两端之间能够传输的最大分组.如果业务系统客户端与服务端两端传输的数据包超过最大传输单元,那么会将数据包进行分片传输。文章所说当接口为mtu为1464很慢,卡!只要一遇到分部客户端与服务器之间有数据交互的时候,就异常的卡,有时软件直接无响应。首先,查看慢的原因是什么?是否因为丢包重传导致的访传达室输慢。wireshark抓包软件一抓并知。如果是因为丢包引起,就接着查看业务交互的数据是否允许进行分片(DF位是否置1),如果不允许分片且数据包超过tunnel接口MTU,那么数据包将会被丢弃。

日历

最新日志

链接

分类

最新碎语

- 如果一个人想要做一件真正忠于自己内心的事情,那么往往只能一个人独自去做"——理查德·耶茨

2019-06-25 21:34

- 日后我们知道,真正的人生道路是由内心决定的。不论我们的道路看上去如此曲折、如此荒谬地背离我们的愿望,它终归还是把我们引到我们看不见的目的地。(茨威格《昨日世界》)

2019-03-16 21:27

- 如果你渴望得到某样东西,你得让它自由,如果它回到你身边,它就是属于你的,如果它不会回来,你就从未拥有过它。——大仲马《基督山伯爵》

2018-10-09 22:07

- 人生有两大悲剧:一个是没有得到你心爱的东西;另一个是得到了你心爱的东西。人生有两大快乐:一个是没有得到你心爱的东西,于是可以寻求和创造;另一个是得到了你心爱的东西,于是可以去品味和体验。——弗洛伊德

2018-09-25 18:06

- 一个人越有思想,发现有个性的人就越多。普通人是看不出人与人之间的差别的——布莱兹·帕斯卡尔

2018-08-30 18:44

存档

- 2020年11月(2)

- 2018年1月(1)

- 2017年12月(1)

- 2017年11月(6)

- 2017年6月(1)

- 2017年5月(1)

- 2017年4月(1)

- 2017年3月(1)

- 2016年11月(1)

- 2016年4月(1)

- 2015年7月(2)

- 2015年6月(1)

- 2015年5月(5)

- 2014年12月(1)

- 2014年11月(1)

- 2014年10月(1)

- 2014年8月(1)

- 2014年7月(1)

- 2014年6月(1)

- 2014年5月(1)

- 2014年4月(3)

- 2014年2月(2)

- 2014年1月(2)

- 2013年12月(1)

- 2013年11月(1)

- 2013年10月(2)

- 2013年9月(1)

- 2013年8月(1)

- 2013年7月(3)

- 2013年6月(2)

- 2013年5月(1)

- 2013年4月(3)

- 2013年3月(1)

- 2013年2月(2)

- 2013年1月(2)

- 2012年12月(11)

- 2012年11月(12)

- 2012年10月(12)

- 2012年9月(26)

- 2012年8月(29)

- 2012年7月(18)

- 2012年6月(2)

- 2012年5月(25)

- 2012年4月(16)

- 2012年3月(13)

- 2012年2月(6)

2017-08-14 20:42